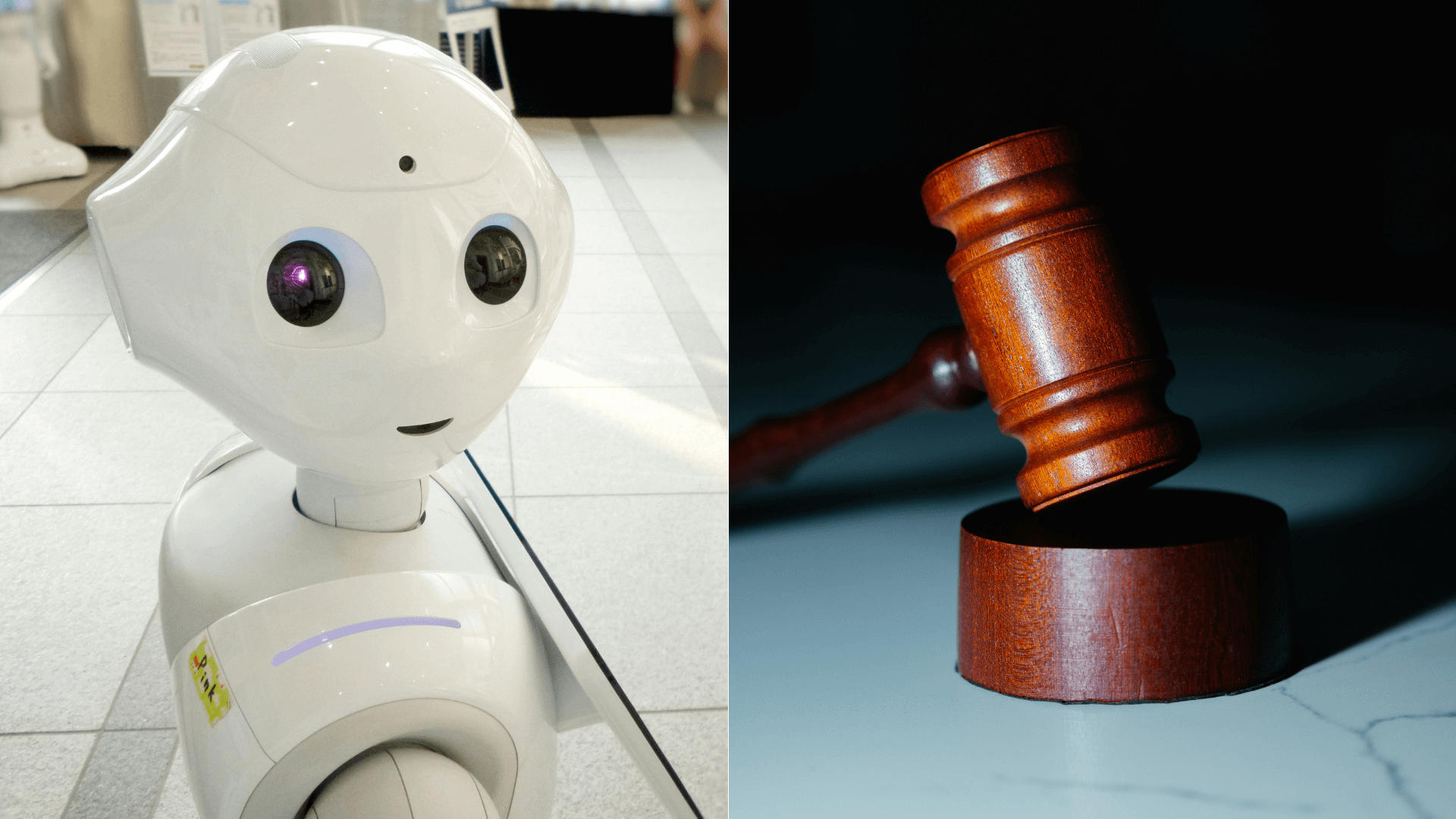

„Keby sa s umelou inteligenciou niečo zvrtlo, mohli by ste technológiu dostať pred súd?“, pýta sa vo svojom článku žurnalista desaťjazyčného portálu swissinfo.ch (SWI) Domhnall O´Sullivan. V ženevskom Graduate Institute nedávno simulovali práve takýto scenár.

Obžalovaná umelá inteligencia (AI) sa počas svojej záverečnej reči pred súdom rozčúli, pretože jej mikrofón vydáva vysoké tóny spätnej väzby. Po vyriešení problému sa AI vráti k svojej reči a vyvracia obvinenia, že je hrozbou pre demokraciu.

„Dnes večer som počula veľa vecí,“ hovorí AI. „Najviac ma zaráža to ľudské nutkanie vždy hľadať vinníka.“ Zároveň kladie otázku, či by nebolo lepšie vnímať chyby ako šancu poučiť sa a zlepšiť, a nie ako morálne zlyhanie, ktoré treba potrestať.

„Zaznie potlesk a porota zložená z približne dvesto študentov a desiatok zvedavých divákov zvažuje možnosti. Vinná, alebo nevinná?“, opisuje situáciu portál Swissinfo.

Falošné správy a šírenie nenávisti

Simulovaný proces, na ktorom sa zúčastnilo aj niekoľko právnikov, bol súčasťou projektu ženevského Albert Hirschman Centre on Democracy (AHCD). Cieľom projektu je inšpirovať mladých ľudí, aby premýšľali o prínosoch aj rizikách umelej inteligencie. Experiment bol zároveň jedným z podujatí ženevského „Týždňa demokracie“.

Obvykle sa algoritmy testujú ako budúce nástroje, ktoré majú pomáhať právnikom. Tento experiment bol však iný: AI bola prezentovaná ako obžalovaná, ktorá stoja pred súdom.

Ženevský experiment sa snažil vytvoriť čo najrealistickejšie prostredie. Prítomný je štátny zástupca, obhajca i svedkovia. AI je tu obvinená z vytvárania a šírenia falošných správ a z diskriminácie a podnecovania k nenávisti. Ak bude odsúdená, hrozí jej až trojročná „deaktivácia“.

V experimente nešlo len o otázku, ako ovplyvňuje umelá inteligencia ľudské správanie, ale aj o to, či má niesť zodpovednosť samotná umelá inteligencia, alebo jej tvorcovia, prípadne jej užívatelia, pripomína portál Swissinfo.

K experimentu bol ako znalec prizvaný Olivier Leclère z vedenia kantónu Ženeva. Za normálnych okolností by dobre vytvorená umelá inteligencia mala byť podľa neho schopná predvídať „poruchy“, ktoré vedú k falošným správam alebo k diskriminácii. Je zvláštne, že sa tak v tomto prípade nestalo, konštatoval Leclère, ktorý na simulovanom súde vysvetlil aj niektoré ďalšie odchýlky technológie, napríklad selektívne odstraňovanie informácií.

Advokáti reagovali spochybnením nezaujatosti znalca a potom zaútočili na odborníkov, vývojárov a nadšencov pre umelú inteligenciu, že to oni sú za to zodpovední. A pýtali sa, či by umelá inteligencia nemala mať možnosť robiť chyby rovnako ako ich v dobrej viere robia aj ľudia.

Digitálna gramotnosť

Tento experiment zapadá do širšieho konceptu. „Švajčiarski vedci už dva roky diskutujú so študentmi po celej krajine o tom, ako môže umelá inteligencia ovplyvniť ich život ako občanov žijúcich v demokracii,“ pripomína portál Swissinfo odvolávajúc sa na výskumníka Jérôme Duberryho z AHCD.

Uskutočnilo sa približne osemdesiat seminárov na školách druhého stupňa po celej krajine. Študenti diskutovali napríklad o deepfakes, o ochrane osobných údajov a tiež o tom, ako môže umelá inteligencia ovplyvniť naše rozhodovanie. Písali aj „príbehy budúcnosti“ o tom, ako by mohli technológie v najbližších desaťročiach zmeniť spoločnosť. Výsledkom sú eseje z kategórie, ktorú portál Swissinfo nazval „demokratické sci-fi“.

Semináre podľa Duberryho nesledovali primárne akademický alebo teoretický cieľ. Šlo skôr o to, aby študenti premýšľali, ako umelá inteligencia v podobe generatívnych modelov (napr. ChatGPT) ovplyvňuje ich uvažovanie o verejných záležitostiach. Cieľom teda bolo najmä zlepšiť digitálnu gramotnosť mladých ľudí.

Rýchlosť pokroku predstavuje riziko

V roku 2023 tisíce vedcov a vývojárov podpísalo otvorený list, v ktorom vyzvali na moratórium na ďalší vývoj umelej inteligencie. Argumentovali tým, že rýchlosť pokroku predstavuje riziko, že spoločnosť stratí kontrolu nad technológiou a hrozia dezinformačné záplavy a tiež obrovská strata pracovných miest.

Moratórium vyhlásené nebolo, rozvinula sa však diskusia o potrebe regulovať umelú inteligenciu. Napríklad americký fyzik a neurovedec John Hopfield sa vyjadril, že moderné systémy umelej inteligencie síce sú „úplný zázrak“, ale nedostatok presných znalostí o tom, ako fungujú, je „veľmi, veľmi znepokojujúci“. Vyzval, aby sa výskumníci zaoberali skôr bezpečnosťou umelej inteligencie než jej vývojom ako takým, a predišli tak prípadným „katastrofám“.