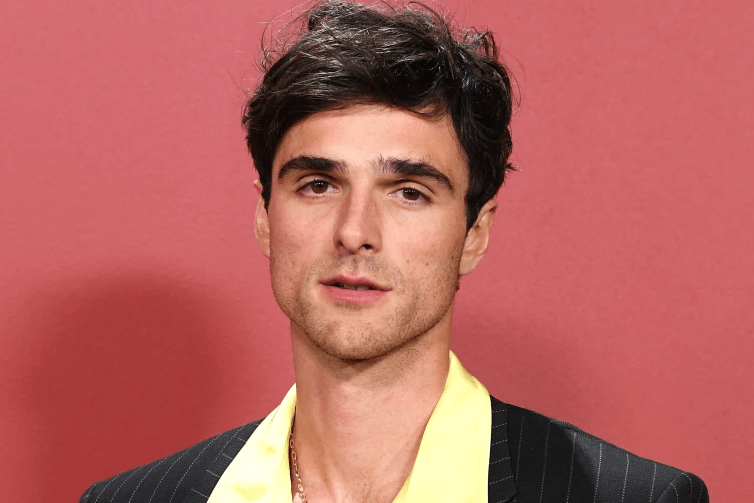

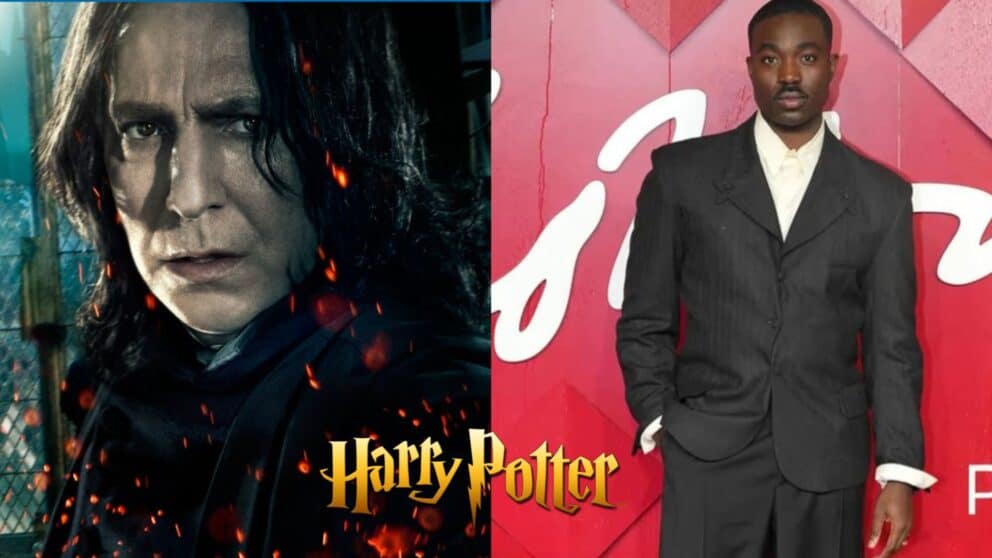

Jacob Elordi, herec známy napríklad zo seriálu Eufória alebo filmu Saltburn, sa stal ďalšou celebritou, ktorá je obeťou sexuálne explicitných deepfake videí. Na internete boli v týchto dňoch zverejnené pornografické zábery vytvorené s pomocou umelej inteligencie.

Sexuálne video s tvárou Elordiho bolo zdieľané na sociálnej sieti X (predtým Twitter) a počas dvoch dní ho videli viac ako tri milióny ľudí, informuje portál NBC News. Video kombinuje Elordiho tvár s telom iného muža z explicitného videa, ktoré pochádza z účtu tvorcu na OnlyFans známej pornografickým obsahom. Ten tvrdí, že mal v čase nakrúcania iba sedemnásť rokov, čo celú situáciu ešte viac komplikuje.

Deepfake technológia využíva umelú inteligenciu na vytvorenie falošných, ale na prvý pohľad veľmi realistických videí. V januári šokovali svet sexuálne ladené falošné fotky Taylor Swift. Umelo vytvorené fotky americkej popovej hviezdy v sexuálnom kontexte zaplavili sociálne siete.

Fanúšikovia speváčky, niektorí americkí zákonodarcovia a dokonca aj Biely dom ostro odsúdili, že bola Swift zneužitá s pomocou umelej inteligencie. Snímky zdieľali na rôznych sociálnych platformách desiatky miliónov ľudí.

Firma Reality Defender, ktorá sa zaoberá kybernetickou bezpečnosťou zameranou na odhaľovanie umelej inteligencie, s deväťdesiatpercentnou istotou určila, že snímky niekto vytvoril s pomocou takzvaného difúzneho modelu. Teda technológiou riadenou umelou inteligenciou, ktorá je dostupná cez viac ako sto tisíc aplikácií.

Celebrity čelia tomuto problému už roky, deepfake videá sú bežné napríklad aj v pornografickom priemysle alebo v politike. Slovensko nie je výnimkou, keď podobné deepfake video zasiahlo do politickej kampane pred septembrovými parlamentnými voľbami v roku 2023.

Deepfake škandály ukazujú, aké nebezpečné môžu byť moderné technológie, ak sú zneužité. Stačí populárne aplikácie, aby ľudia poskytli potrebné podklady na tvorbu falzifikátov – v podobe fotiek či videí – dobrovoľne.

Ešte jednoduchšie je získať vzorku hlasu. Stačí na to dostatočne dlhý telefonát, v ktorom volajúcou správnou taktikou dokáže z volajúceho vylúdiť aj nejakú intonáciu. Nie je si potom zložité predstaviť následný telefonát príbuznému seniorovi, ktorého takto „ukradnutou“ vzorkou hlasu vnúčika útočník prinúti poslať peniaze alebo nainštalovať si malware, ktorý môže viesť k vykradnutiu bankového účtu.